orion_interview_algorithms

算法工程师

团队情况,角色扮演

机器学习算法评价指标:

- 正确率 (TP+TN)/(P+N)

- 错误率(FP+FN)/(P+N)

- 灵敏度 TP/P

- 特异性 TN/N

- 精度 TP/(TP+FP)

- 召回率 TP/(TP+FN)

- F1=2xprecisionxrecall/(precision+recall)

- Receiver Operating Characteristic Curve (ROC, 受试着工作特征曲线,越接近 1,模型越好,0.5 表示模型没有预测能力,无限接近 1,过拟合)

- Precision Recall Curve

- Average Precision (AP, 越高越好,模型性能好)

- 回归算法优缺点及适用场景:

| 算法名称 | 核心思想 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| 线性回归 | 找到一条直线(或超平面)使得所有数据点到该直线的平方误差和最小。 | 简单、可解释性强、计算效率高。 | 对非线性关系和数据噪声敏感。 | 特征与目标之间存在明显线性关系。 |

| 多项式回归 | 线性回归的扩展。通过为特征添加次方项(如 $x2$, $x3$)来拟合非线性关系。 | 可以捕捉更复杂的数据模式。 | 容易过拟合(特别是高次多项式)。 | 数据趋势呈曲线状,如增长速率变化。 |

| 决策树回归 | 通过构建一棵“树”,递归地将数据分割成更小的区域,并用每个区域内目标的平均值作为预测值。 | 能处理非线性关系,无需特征缩放,可解释性好。 | 非常容易过拟合,对数据微小变化敏感。 | 数据中存在复杂的 if-then 规则。 |

| 随机森林回归 | 集成学习算法。构建多棵决策树,并将它们的预测结果取平均作为最终预测。 | 精度高,抗过拟合能力强,能处理高维数据。 | 失去了单棵决策树的可解释性,计算开销大。 | 绝大多数回归任务的优秀基准模型。 |

| 支持向量回归 | 不是试图最小化误差,而是试图找到一个“间隔带”,使得尽可能多的数据点落在这个带内。 | 对异常值不敏感,在高维空间中表现良好。 | 数据量大时训练慢,需要仔细调参。 | 数据中存在异常值,或特征维度非常高。 |

| 梯度提升回归 | 另一种强大的集成方法。逐步(串行)地构建树,每一棵树都致力于纠正前一棵树的错误。 | 预测精度通常极高,是竞赛中的“大杀器”。 |

F1分值无限接近于1

在模型训练中 F1值无限接近于1,大概率不是模型效果极佳,而是出现了过拟合或数据/标签问题,具体原因及纠正措施如下:

一、 核心问题分析

严重过拟合 这是最常见的原因。模型在训练集上表现完美,但在验证集/测试集上F1值会断崖式下跌。

- 本质:模型“死记硬背”了训练数据的特征和标签,而非学习到通用规律。

- 典型场景:数据量小、模型复杂度高(如大参数量的Transformer模型做简单分类)、特征维度远超样本数。

数据或标签缺陷

- 标签泄露:训练数据的特征中包含了标签信息(如在RAG检索效果评估中,误将“检索结果是否被LLM引用”的标签混入输入特征)。

- 数据分布异常:训练集和测试集高度重叠,或测试集样本是训练集的子集。

- 类别不平衡+标签噪声:样本集中某一类占比极高,模型无脑预测多数类即可获得高F1;或标签标注错误,导致模型学到错误规律。

评估方式错误

- 仅在训练集上评估F1,未划分验证集/测试集;

- 评估指标计算错误(如混淆矩阵的TP、FP、FN统计错误,尤其在多分类任务中)。

二、 针对性纠正措施

解决过拟合的核心手段

- 降低模型复杂度:减少模型层数、参数量,或改用轻量级模型(如用BERT-base替代BERT-large);在RAG场景中,可降低检索重排序模型的复杂度。

- 加入正则化策略:

- 权重正则化:添加 L1/L2 正则项,限制参数规模;

- 结构正则化:使用 Dropout(随机失活神经元)、DropConnect;在深度学习模型中加入早停(Early Stopping),验证集F1不再提升时立即停止训练。

- 扩充训练数据:通过数据增强(如文本的同义词替换、回译、随机裁剪)增加样本多样性;在RAG评估中,构建更多真实场景的查询-检索结果对。

- 使用集成学习:训练多个弱模型,通过投票/加权融合结果,降低单一模型的过拟合风险。

修复数据与标签问题

- 检查并消除标签泄露:梳理特征工程流程,确保特征中不包含标签相关信息;例如在RAG检索评估中,输入特征不能包含“是否命中正确文档”的标签。

- 规范数据划分:严格按照 7:2:1 划分训练集、验证集、测试集,确保三者无交集;使用分层抽样,保证各数据集的类别分布一致。

- 清洗标签与样本:人工核查标注错误的样本,剔除噪声数据;针对类别不平衡,采用过采样(SMOTE)、欠采样或加权损失函数(如Focal Loss)平衡类别权重。

修正评估方式

- 强制划分独立测试集:必须在未参与训练和验证的测试集上评估F1,才能反映模型真实泛化能力。

- 多维度评估:除了F1,还需结合精确率、召回率、混淆矩阵分析;在RAG场景中,需额外评估检索准确率、生成事实一致性,避免单一指标误导。

三、 RAG 场景的特殊注意事项

若该模型用于 RAG 的检索效果评估(如判断检索结果是否相关),F1 趋近于1 还可能是: - 检索评估的样本过于简单(如查询和文档关键词完全一致),需引入更复杂的测试案例(如隐喻、歧义查询); - 评估指标与实际业务脱节,需结合端到端效果(如LLM生成答案的准确率)综合判断。

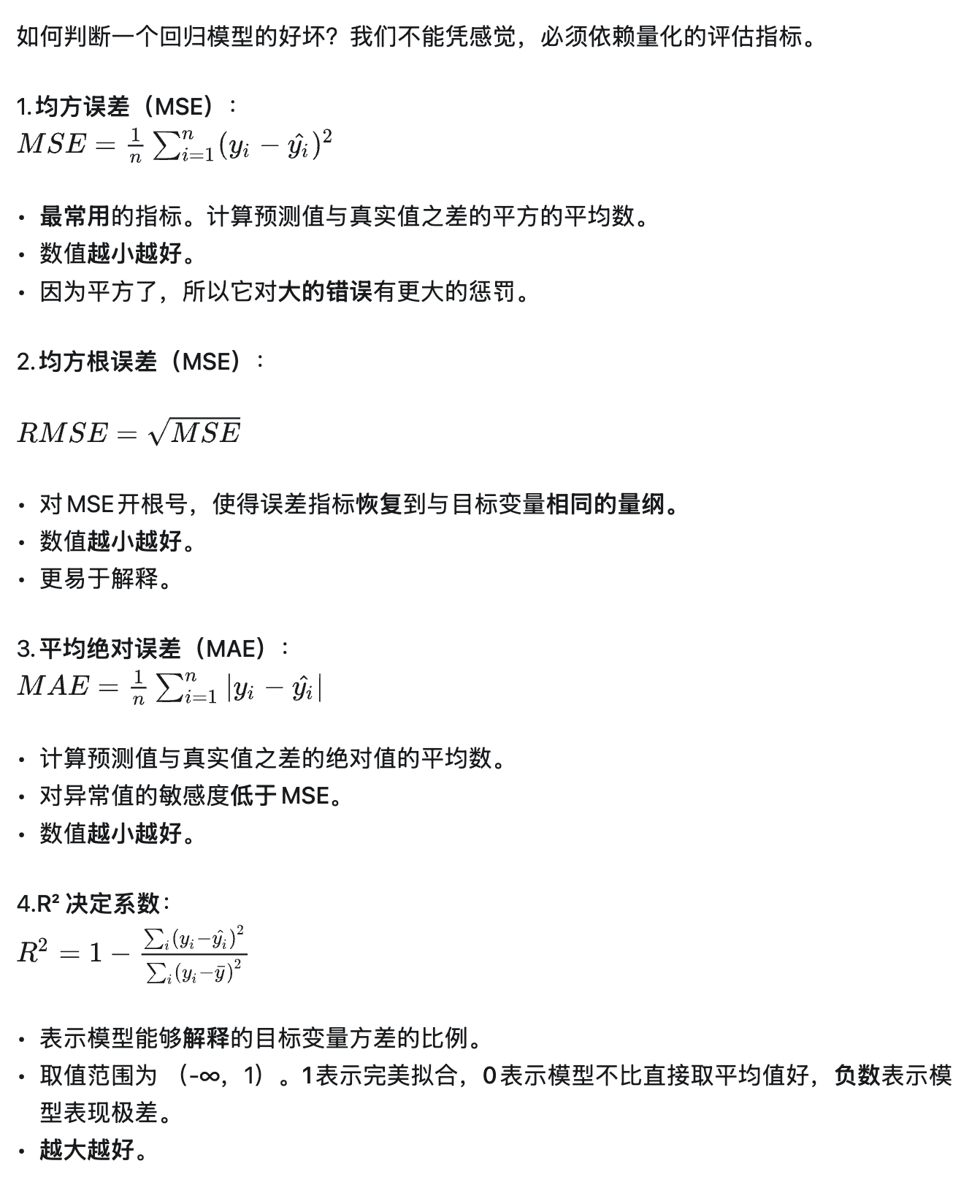

模型评估指标

RAG vs Graph Rag

传统 RAG 以文本块向量检索为主,适合单跳问答与细节查询,开发快、成本低;Graph RAG 融合知识图谱,通过实体 - 关系建模与图遍历,在多跳推理、复杂语义关联与可解释性上更优,但构建与维护成本更高。传统 RAG 是“快而简”的基础方案,Graph RAG 是“准而深”的进阶方案。选型核心看业务对推理复杂度、可解释性、更新频率的需求:简单场景选传统 RAG;复杂推理与实体密集场景选 Graph RAG,或采用混合架构平衡效率与效果。

核心定义与本质差异

- 传统 RAG:将非结构化文本切分为块,经 Embedding 存入向量库;检索时通过向量相似度匹配返回 Top - k 文本块,供 LLM 生成答案,核心是“文本块+向量检索”的扁平知识组织。

- Graph RAG:先从文本提取实体、关系构建知识图谱(节点为实体,边为关系),检索结合向量匹配与图遍历(如最短路径、子图查询),核心是“结构化图谱+混合检索”的关联知识组织,强化多跳推理与全局语义理解。

传统 RAG 以文本块向量检索为主,适合单跳问答与细节查询,开发快、成本低;Graph RAG 融合知识图谱,通过实体 - 关系建模与图遍历,在多跳推理、复杂语义关联与可解释性上更优,但构建与维护成本更高。下面从核心维度展开对比,并给出选型建议。

关键维度对比表

| 对比维度 | 传统 RAG | Graph RAG |

|---|---|---|

| 知识表示 | 文本块向量,无显式结构,语义依赖 Embedding | 实体 - 关系三元组,图结构,语义可解释 |

| 检索机制 | 纯向量相似度匹配,易漏跨块关联 | 向量匹配+图遍历,支持实体扩展与路径推理 |

| 推理能力 | 擅长单跳、细节查询,多跳推理易失效 | 适配多跳、因果/关联推理,支持复杂逻辑链 |

| 可解释性 | 低,依赖文本块相似度排序,难追溯来源 | 高,可通过子图、路径展示推理依据 |

| 构建成本 | 低,仅文本切块、Embedding、向量入库 | 高,需实体识别、关系抽取、图谱构建与维护 |

| 更新效率 | 高,新增文本块 Embedding 后直接入库 | 中 - 低,新增数据可能需重新抽取关系并更新图谱 |

| 存储特性 | 向量占比高,随文本量线性增长 | 结构紧凑,实体去重后存储效率更高 |

| 检索性能 | 低延迟,适合高并发简单查询 | 视图复杂度,纯向量检索快,复杂图遍历可能增加延迟 |

| 适用场景 | 通用问答、文档检索、简单知识补充 | 多跳问答、知识图谱应用、实体推理、复杂摘要 |

性能与效果差异(基于最新研究)

- 问答任务:传统 RAG 在单跳、细粒度细节题上更优;Graph RAG 在多跳、推理密集型问题上表现突出。

- 摘要任务:传统 RAG 能精准捕捉细节;Graph RAG 可生成多维度、全局视角的摘要,适合跨文档主题分析。

- 检索召回:传统 RAG 可能因文本块边界丢失关联信息;Graph RAG 通过图谱关联,召回更全面,减少“碎片化”问题。

典型应用场景选型

- 优先选传统 RAG

- 快速落地通用问答、文档知识库(如产品手册检索)。

- 数据频繁更新且预算有限(如新闻、实时资讯)。

- 以细粒度文本细节查询为主,无需复杂推理。

- 优先选 Graph RAG

- 多跳推理场景(如“小区 A 的开发商旗下还有哪些在上海浦东的楼盘”)。

- 实体密集型任务(如人物关系查询、行业知识图谱问答)。

- 对可解释性要求高(如金融风控、医疗诊断辅助)。

- 需跨文档语义关联与全局分析(如科研文献综述、行业趋势总结)。

实施与成本权衡

- 传统 RAG:技术栈成熟(如 LangChain+Chroma/Faiss),开发周期短,适合快速验证 MVP;但语义理解浅,多跳查询易出幻觉。

- Graph RAG:需图数据库(如 Neo4j、NebulaGraph)、NER/关系抽取模型,初期投入大;可通过分层摘要(如微软 GraphRAG 的社区聚类)提升全局理解,长期适合复杂场景迭代。

融合方案(推荐)

多数场景可采用“向量检索+图谱检索”混合架构:

- 基础查询走传统 RAG,保证低延迟。

- 检测到多跳/推理查询时,触发 Graph RAG,补充实体关系与路径信息。

- 用图谱的实体 - 关系校验 RAG 结果,降低幻觉率。

说一下 rag 技术 R A G,第一数据特点,第二,分块如何切片,第三使用的模型,第四模型对应向量维维度,这四者之间有什么制约关系?

RAG技术四要素的制约关系

RAG(检索增强生成)中数据特点、分块切片、使用模型、向量维度四者是层层制约、相互适配的耦合关系,核心逻辑是让分块和向量维度匹配数据特性,再让模型适配向量空间以实现高效检索+精准生成。

数据特点 → 分块切片:基础制约 数据的类型(结构化/非结构化)、粒度(短文本/长文档)、领域特性(专业术语密度/语义连贯性)直接决定分块策略:

- 若数据是短文本类(如租房APP的房源标签、用户咨询短句),适合小粒度分块(50-100 tokens),避免信息冗余;

- 若数据是长文档类(如租房合同、房源详情页),需按语义边界分块(如按段落/条款拆分,200-500 tokens),防止切断核心语义;

- 若数据是结构化类(如房源价格、面积表格),需先提取结构化字段再分块,分块切片需保留字段关联关系。 反向制约:不合理的分块会破坏数据原有语义,导致后续检索时无法匹配到关键信息。

分块切片 → 向量维度:适配制约 分块的长度和语义复杂度决定向量维度的选择:

- 小粒度分块(语义单一)无需高维向量,用768维(如BERT-base)即可精准表征,高维向量会引入冗余;

- 大粒度分块(语义丰富/专业术语多,如租房合同条款)需更高维向量(如1024维/1536维,如text-embedding-ada-002),低维向量会丢失关键语义信息; 反向制约:向量维度与分块不匹配时,会出现“维度浪费”或“语义压缩失真”,直接降低检索召回率。

向量维度 & 分块 → 使用模型:选型制约 向量维度由嵌入模型(Embedding Model)决定,而嵌入模型的选型需同时适配分块粒度和向量维度需求:

- 小粒度分块+低维向量(768维):选轻量级模型(如BERT-base、all-MiniLM-L6-v2),速度快、显存占用低,适合本地部署;

- 大粒度分块+高维向量(1024+维):选大模型或专用嵌入模型(如text-embedding-ada-002、bge-large-en-v1.5),能捕捉复杂语义,但对硬件要求更高; 额外制约:检索模型(如FAISS、Milvus)的索引效率也受向量维度影响——高维向量需用更高效的索引算法(如HNSW),否则检索速度会大幅下降。

使用模型 → 数据特点:反向适配 模型的领域适配性会反过来要求数据预处理调整:

- 若使用通用嵌入模型处理租房领域专业数据,需在分块时强化领域关键词(如“押一付一”“整租”),否则模型难以捕捉领域语义;

- 若使用轻量化模型处理长文本数据,需进一步拆分分块粒度,适配模型的上下文窗口限制。

总结

四者的核心制约链路为: 数据特点决定分块策略 → 分块粒度决定向量维度 → 分块+向量维度决定模型选型 → 模型特性反向要求数据适配 最终目标是实现“检索时召回率最高、生成时内容精准度最优”的RAG效果。

针对 RAG 在检索偏差、生成幻觉、工程维护、复杂推理等核心缺点,可采取以下针对性措施,能直接显著改善系统性能:

一、 解决检索精度低、噪声多的核心措施

混合检索策略(向量 + 关键词) 向量检索负责语义匹配,关键词检索(如 BM25)负责精确匹配术语、缩写、专有名词,两者结果加权融合,解决隐喻、术语不匹配导致的误检/漏检问题。 落地示例:先用 BM25 筛选出 Top 50 相关文档,再用向量检索从中选出 Top 10 送入 LLM,兼顾召回率与精确率。

文档智能切分 + 元数据增强 摒弃固定长度切分,采用语义切分(基于段落、标题、句子边界,结合 embedding 相似度判断),避免关键信息被截断;同时为每个文本块添加元数据(如文档类型、发布时间、来源可信度),检索时可按元数据过滤(如优先选择近 3 个月的租房政策文档)。

检索重排序(Cross-Encoder 精排) 先用轻量模型(如 BERT-base)做粗排,再用 Cross-Encoder 计算“查询 - 文本块”的匹配得分,重新排序结果,大幅降低相似但不相关内容的占比。

二、 根治生成幻觉、信息整合差的关键手段

强制引用标注 + 事实校验 设计 Prompt 要求 LLM 仅基于检索结果生成答案,并标注答案对应的文本块来源(如「参考文档 1 第 3 段」);同时引入事实校验模块,将生成结果与检索内容对比,不一致则拒绝输出或重新生成。 工具选型:可选 LlamaIndex 的

ResponseEvaluator或 LangChain 的RetrievalQAWithSourcesChain。结构化 Prompt 与思维链(CoT)提示 构建标准化 Prompt 模板,明确指令:

“基于以下检索内容,分点回答问题,禁止使用外部知识;若检索内容不足,直接说明‘暂无相关信息’”;对于复杂问题,加入思维链提示(如“先分析问题需要哪些信息,再从检索结果中提取对应内容,最后整合答案”),提升信息整合逻辑。检索结果去重与融合 对检索到的重复或高度相似文本块去重,避免冗余信息干扰 LLM;对于多来源冲突信息,Prompt 要求 LLM 标注冲突点并说明“不同来源存在差异,建议参考权威文档”。

三、 降低工程维护成本、提升扩展性的落地方案

自动化知识库更新与版本管理

- 增量更新:监控数据源变化(如租房平台新政策、房源信息),仅对新增/修改文档向量化,避免全量重建向量库;

- 版本管理:为知识库设置版本号,支持回滚(如更新后效果下降,可切回上一版本);

- 自动化清洗:用规则 + 模型过滤低质量内容(如重复房源描述、无效广告文本)。

轻量化向量库选型与性能优化 针对实时场景(如租房 APP 语音对话),选择支持增量索引、低延迟检索的向量库:

- 小规模场景:FAISS(CPU 模式)+ Redis 缓存热门查询结果;

- 大规模场景:Milvus/Zilliz Cloud,支持分片存储与负载均衡,降低检索延迟。

引入可解释性工具链 采用 LlamaIndex、LangChain 等框架的可视化工具,追踪“查询→检索→生成”全链路,记录每个环节的输入输出,方便定位问题(如检索结果为空、生成偏离原文等),满足运维与合规审计需求。

四、 突破复杂推理能力不足的进阶方案

RAG + Agent 架构(多轮检索推理) 引入 Agent 作为决策层,当单次检索无法回答问题时,Agent 自动拆解问题为子查询(如“租房押金退还条件”→ 子查询 1:押金退还法律依据;子查询 2:违约情况下的扣除规则),分轮检索后整合结果,解决多跳推理问题。 落地框架:LangChain Agent、AutoGPT。

Self-RAG 自优化机制 让 LLM 自主判断检索结果是否足够回答问题:若不足,则生成新的检索词重新检索;若足够,则直接生成答案,形成“检索 - 评估 - 再检索”的闭环,提升复杂问题的处理能力。

命名实体识别 NER

目标是从非结构化文本中识别并分类预定义类别的实体(如人名、地名、机构名、时间、产品名等),是 RAG、知识图谱构建、信息抽取的核心前置步骤。

任务类型

- Flat NER:扁平命名实体识别,实体间无嵌套关系,是最基础的任务类型。

示例:[北京市]LOC [朝阳区]LOC 的 [国贸中心]ORG - Nested NER:嵌套命名实体识别,一个实体包含在另一个实体内部。

示例:[北京大学]ORG 的 [北大图书馆]ORG(“北大图书馆”嵌套在“北京大学”相关语境中) - Discontinuous NER:不连续命名实体识别,实体的文本片段不连续,但语义上属于同一个实体。

示例:在房产文本中[万科]开发商 [2023年开盘的] 城璟园→ 合并为实体[万科城璟园]楼盘名

标注范式

NER 的标注本质是序列标注任务,常用标注体系有 3 种,核心是区分实体的边界与类别: | 标注体系 | 标签定义 | 示例(句子:张三在阿里巴巴工作) | 优缺点 | |----------|----------|----------------------------------|--------| | BIO | B-前缀:实体开头;I-前缀:实体内部;O:非实体 | B-PER 张三,O 在,B-ORG 阿里巴巴,I-ORG 巴巴,O 工作 | 简单易用,适合 Flat NER;无法区分实体结束边界 | | BIOES | 在 BIO 基础上增加 E(实体结尾)、S(单个字符实体) | B-PER 张,E-PER 三,O 在,B-ORG 阿,I-ORG 里,I-ORG 巴,E-ORG 巴,O 工作 | 精准区分实体起止,减少边界歧义;标注成本略高 | | BMES | B(开头)、M(中间)、E(结尾)、S(单个实体) | 同 BIOES 逻辑,仅标签名称不同 | 适合中文等分词粒度较细的语言 |

核心评价指标

NER 模型性能需从精准度、召回率、完整性三个维度评估,核心指标为:

- 精确率(Precision):模型识别的实体中,真实正确的比例 → 衡量“不标错”。

- 召回率(Recall):文本中所有真实实体被模型识别出的比例 → 衡量“不漏标”。

- F1-Score:精确率和召回率的调和平均 → 综合性能指标,是 NER 任务的核心评价标准。

- 实体级 F1:区别于 token 级 F1,以完整实体为单位计算(更符合业务实际需求,避免“部分标注正确”的干扰)。

选型核心原则

- 快速验证、无标注数据 → 规则/词典 + 大模型 Prompt 混合方案。

- 工业级落地、有标注数据 → 预训练模型(如 BERT-base)+ CRF 微调(平衡精度与速度)。

- 垂直领域高精度需求 → 领域预训练模型(如房产领域 BERT)+ 领域标注数据微调。

- 低延迟部署需求 → 轻量模型(DistilBERT、ERNIE-tiny)量化压缩。

“数据为先、模型适配、工程优化” 三大原则,具体实践步骤如下:

1. 数据层:高质量标注是核心

NER 模型性能 70% 取决于数据质量,需重点关注以下 3 点:

- 标注规范统一

- 明确业务实体类别(避免模糊定义,如房产场景中“面积”需区分“建筑面积”和“套内面积”)。

- 统一标注范式(推荐 BIOES,减少边界歧义)。

- 标注一致性校验(多人标注相同文本,一致性需 ≥ 90%)。

- 数据增强策略

针对低资源场景,通过以下方法扩充标注数据:

- 同义词替换:如“三居室”→“三室一厅”、“开发商”→“房企”。

- 实体掩码替换:将文本中实体替换为同类别其他实体(如“万科城”→“保利花园”)。

- 回译增强:中文 → 英文 → 中文,生成语义相似的新文本。

- 数据划分原则 训练集:验证集:测试集 = 7:1:2,确保测试集与训练集分布一致(避免领域偏差,如房产文本需覆盖不同城市、户型、价格段)。

2. 模型层:调优与适配技巧

- 模型结构选型

优先选择 “预训练语言模型 + CRF” 架构:

- 预训练模型负责捕捉语义特征(如 BERT 对“万科城”的语义编码)。

- CRF 层负责优化序列标注的全局一致性(避免出现“B-楼盘名”后接“O”的不合理标注)。

- 关键调参技巧

- 学习率:预训练模型部分采用 小学习率(2e-5 ~ 5e-5),CRF 层采用 大学习率(1e-3)。

- 批量大小(Batch Size):根据 GPU 显存调整,推荐 16/32,避免过拟合。

- 训练轮数(Epoch):5 ~ 10 轮,通过验证集 F1 曲线早停(防止过拟合)。

- 垂直领域适配

通用预训练模型在垂直领域表现有限,需进行 领域适配微调:

- 用领域无标注文本对预训练模型进行 继续预训练(如用 10 万条房产新闻、楼盘介绍文本)。

- 用少量领域标注数据进行 任务微调,大幅提升实体识别精度。

3. 工程层:推理优化与部署

- 推理加速方案

- 模型量化:将 FP32 模型量化为 INT8/FP16,减少显存占用,提升推理速度(精度损失 ≤ 2%)。

- 模型裁剪:去除预训练模型的冗余层(如 DistilBERT 是 BERT 的 70% 大小,速度提升 60%)。

- 批量推理:将多条文本打包批量处理,提升吞吐量(适合离线任务)。

- 后处理优化

解决模型识别的“噪声”问题,提升下游任务可用性:

- 实体去重:同一文本中重复识别的实体(如“朝阳区”出现两次)合并为一个。

- 规则校验:用领域词典过滤错误实体(如识别出“1000㎡ 的一居室”,通过规则判定为不合理)。

- 实体链接:将识别出的实体链接到知识图谱(如“万科城”链接到图谱中的具体楼盘节点)。

- 部署架构建议

- 在线低延迟场景 → TensorRT/ONNX Runtime 加速 + CPU/GPU 混合部署。

- 离线大规模处理 → 分布式推理框架(如 Ray) 批量处理文本。

4. 下游任务协同优化

NER 作为 RAG、Graph RAG 的前置步骤,需与下游流程协同设计:

- 与 RAG 协同:NER 识别的实体可作为 检索关键词,提升向量检索的精准度(如检索“上海浦东 三居室”时,优先用实体过滤文本库)。

- 与 Graph RAG 协同:NER 识别的实体是知识图谱的 节点基础,需与关系抽取任务联动(如识别出“万科城”(楼盘)和“万科集团”(开发商)后,抽取“开发-被开发”关系)。

四、常见问题与解决方案

| 常见问题 | 原因 | 解决方案 |

|---|---|---|

| 嵌套实体识别错误 | 模型无法捕捉实体层级关系 | 采用 Nested NER 专用模型(如 SpanBERT);用大模型 Prompt 引导识别嵌套结构 |

| 不连续实体漏标 | 传统序列标注模型无法处理非连续文本 | 采用基于跨度(Span)的模型;后处理阶段通过规则合并离散实体片段 |

| 低资源领域精度低 | 标注数据不足、通用模型领域适配差 | 规则+小样本微调混合方案;利用大模型进行伪标注(生成标注数据) |

| 推理延迟高 | 模型参数量大、未优化 | 模型量化/裁剪;采用轻量模型;批量推理 |

五、工具链推荐

| 环节 | 推荐工具/框架 |

|---|---|

| 数据标注 | LabelStudio(开源)、京东众智(商业) |

| 模型训练 | Hugging Face Transformers、PyTorch Lightning |

| 模型加速 | ONNX Runtime、TensorRT、TorchScript |

| 部署框架 | FastAPI(在线推理)、Ray(分布式推理) |

Transformer 与 BERT 核心架构详解

以下内容可用于面试提问、岗位要求撰写,帮助你判断候选人对Transformer 底层原理和BERT 模型设计的掌握程度。

一、 Transformer 核心架构(2017年《Attention Is All You Need》)

Transformer数据训练核心的三个步骤为数据预处理与构建输入、模型前向传播与损失计算、反向传播与参数优化。

数据预处理与构建输入 对原始文本/序列数据进行清洗、分词、编码,生成模型可识别的token序列;同时构建attention mask、position encoding等关键输入组件,将数据封装为模型训练所需的批次数据。

模型前向传播与损失计算 输入数据经过Transformer的encoder-decoder结构(或单encoder/decoder)完成特征提取与序列生成;通过预设的损失函数(如交叉熵损失),计算模型预测结果与真实标签之间的误差值。

反向传播与参数优化 基于计算出的损失值,利用链式法则反向计算模型各层参数的梯度;通过优化器(如Adam、SGD)更新参数,最小化损失函数,迭代提升模型的预测精度。

Transformer 是一种基于自注意力机制的序列建模架构,彻底抛弃 RNN/CNN 的串行计算模式,采用全并行处理,是 BERT、GPT 等大模型的基础。其架构分为编码器(Encoder)和解码器(Decoder)两大对称模块。

1. 整体结构

输入序列 → 嵌入层+位置编码 → 编码器栈 → 解码器栈 → 线性层+Softmax → 输出序列

2. 编码器(Encoder):N 层堆叠(通常 N=6)

每层包含 2 个子层 + 残差连接 + 层归一化,子层输出公式:LayerNorm(x + Sublayer(x))

- 子层1:多头自注意力机制(Multi-Head Self-Attention)

核心是计算序列中每个 token 与其他所有 token 的依赖关系,分为“多头”是为了捕捉不同维度的语义关联。

计算步骤:

1. 对输入 X 生成 Query(Q)、Key(K)、Value(V)三个矩阵(通过线性变换);

2. 计算注意力分数:Attention(Q,K,V) = Softmax(QK^T/√d_k)V(√d_k 防止梯度爆炸);

3. 拆分为多个“头”并行计算,再拼接结果,输出最终注意力特征。

- 子层2:位置前馈网络(Position-wise Feed-Forward Network)

对每个 token 独立做两次线性变换 + 激活函数(ReLU),公式:FFN(x) = max(0, xW1 + b1)W2 + b2。

3. 解码器(Decoder):N 层堆叠(通常 N=6)

每层包含 3 个子层 + 残差连接 + 层归一化,比编码器多一个“编码器-解码器注意力层”: - 子层1:掩码多头自注意力机制(Masked Multi-Head Self-Attention) 加入掩码(Mask),防止模型看到当前 token 之后的内容(保证训练时的单向性,适配生成任务)。 - 子层2:编码器-解码器注意力机制(Encoder-Decoder Attention) Query 来自解码器上一层输出,Key 和 Value 来自编码器最终输出,作用是让解码器关注输入序列的关键信息(如机器翻译中目标语言对齐源语言)。 - 子层3:位置前馈网络:与编码器完全一致。

4. 关键辅助组件

- 位置编码(Positional Encoding):Transformer 无循环结构,无法捕捉序列顺序,通过正弦/余弦函数为每个 token 注入位置信息,与词嵌入相加后输入编码器。

- 线性层 + Softmax:解码器输出经线性层映射到目标词表维度,Softmax 输出每个 token 的概率分布。

二、 BERT 核心架构(2018年《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》)

BERT 的全称是 Bidirectional Encoder Representations from Transformers,即基于 Transformer 编码器的双向预训练语言模型。其核心是仅使用 Transformer 的编码器部分,通过双向注意力实现对上下文的深度理解。

1. 整体结构

输入文本 → 输入嵌入层 → Transformer 编码器栈 → 输出向量(用于下游任务)

2. 核心设计亮点

(1) 仅保留 Transformer 编码器

BERT 专注于语言理解任务(如分类、NER、语义匹配),不需要生成能力,因此舍弃了解码器,直接堆叠 Transformer 编码器(基础版 12 层,大型版 24 层)。 - 编码器的双向自注意力是 BERT 的核心优势:每个 token 可以同时关注左右两侧的上下文(区别于单向的 GPT)。

(2) 特殊的输入嵌入层(3 种嵌入相加)

BERT 的输入嵌入是词嵌入 + 段嵌入 + 位置嵌入的总和,适配多种任务输入:

- 词嵌入(Token Embedding):每个 token 对应的向量表示,包含 [CLS](分类标记,用于分类任务)和 [SEP](分隔标记,用于分隔句子对);

- 段嵌入(Segment Embedding):用于区分句子对(如“句子A [SEP] 句子B”),标记哪些 token 属于句子 A,哪些属于句子 B;

- 位置嵌入(Position Embedding):与 Transformer 不同,BERT 采用可学习的位置嵌入(而非固定的正弦函数),适配不同长度的序列。

(3) 预训练任务设计(决定模型的泛化能力)

BERT 通过无监督预训练 + 有监督微调的模式适配下游任务,预训练包含两个核心任务:

1. 掩码语言模型(Masked Language Model, MLM)

- 随机掩码输入中 15% 的 token(替换为 [MASK]),让模型预测被掩码的 token;

- 目的:强制模型学习双向上下文信息,提升语义理解能力。

2. 下一句预测(Next Sentence Prediction, NSP)

- 输入句子对(A, B),其中 50% 是真实的上下句,50% 是随机拼接的句子,让模型判断 B 是否是 A 的下一句;

- 目的:让模型学习句子间的逻辑关系,适配问答、文本匹配等任务。

3. 适配下游任务的方式

BERT 预训练完成后,通过简单的微调即可适配各类下游任务,核心是共享预训练权重,仅添加少量任务相关层:

- 分类任务:取 [CLS] 标记的输出向量,接一个全连接层 + Softmax;

- 命名实体识别(NER):取每个 token 的输出向量,接全连接层 + Softmax,预测实体类型;

- 句子对匹配:输入 [CLS] 句子A [SEP] 句子B [SEP],取 [CLS] 向量做分类。

三、 招聘考察核心要点(判断候选人能力)

Transformer 层面

- 能否解释自注意力 vs 多头注意力的区别?能否推导注意力分数的计算公式?

- 能否说明编码器 vs 解码器的核心差异?掩码注意力的作用是什么?

- 位置编码的作用是什么?Transformer 为什么需要位置编码?

BERT 层面

- 能否说明 BERT 与 Transformer 的关系?为什么 BERT 只用编码器?

- MLM 任务的设计逻辑是什么?相比单向语言模型有什么优势?

- BERT 的输入嵌入包含哪三部分?

[CLS]和[SEP]的作用分别是什么?

工程落地层面

- 如何用 BERT 解决文本分类/语义匹配任务?是否有微调 BERT 的实战经验?

- 知道哪些 BERT 的改进模型(如 RoBERTa、ALBERT)?核心改进点是什么?

BERT 的作用一句话说就是:帮模型真正看懂一句话里前后文的关系,从而做更好的语言理解。

稍微展开说它能做什么、为什么有用:

双向理解上下文 传统模型要么从左到右看,要么从右到左看,BERT 一次性从两边看,所以对这种中文里的省略、指代、语气词都更稳。

做“通用语义底座” BERT 是在大规模语料上先预训练的,学到“中文/英文是怎么说话的”。之后你拿到自己的业务(比如租房描述)上只要做一点点微调,它就能适应你的任务——省数据、省时间。

适配很多下游任务

分类:这句话是需求还是闲聊?是找房还是报修?

序列标注(NER):这句话里哪些是价格、房型、地点?

句子对/匹配:用户说的这句话和哪条房源描述最像?

问答:问题里要的字段在文本哪里?

把文本变成“可计算”的向量 BERT 会把一句话、一个词变成向量表示,你就能拿这些向量去做相似度、召回、排序,这对“用户说话 → 找相似房源”特别有用。

跟你现在的租房业务的直接关系:

用户一句很口语的描述 → 用 BERT 做 序列标注 → 标出价格、面积、地点、设施词

用户说“不要太贵”这种带情绪/约束的 → 用 BERT 做 意图/属性分类,识别“价格上限型约束”

用 BERT 的向量 → 做 语义召回,把说“虹口和平公园附近想要能养狗的房子”这种话映射到最像的房源

所以,BERT 的核心作用就是:给你一个通用的、能看懂上下文的语言理解能力,你再在它上面接你自己的租房任务就行了。

torchCRF

torchCRF 是一个用于条件随机场(CRF,Conditional Random Field)的 PyTorch 实现,它是用于序列标注任务中的一种常用模型。CRF 特别适用于需要考虑上下文依赖关系的任务,比如 命名实体识别(NER)、词性标注(POS tagging)、语音识别 等任务。

- 什么是 CRF?

条件随机场(CRF) 是一种用于标注和分割序列数据的模型,尤其擅长处理 标签之间的依赖关系。它的基本思想是,在给定输入序列的情况下,最大化输出标签序列的条件概率。CRF 可以看作是一个全局的概率模型,它在序列标注时考虑了标签之间的 相互依赖,而不仅仅是每个标签的独立预测。

简单来说,CRF 模型比传统的分类器(如支持向量机、逻辑回归)要强大,因为它能够考虑标签间的 相邻依赖关系,这对于许多自然语言处理(NLP)任务至关重要。

- torchCRF 的作用

torchCRF 是一个为 PyTorch 提供的 CRF 实现,它为你提供了训练和推理时所需要的工具,尤其适用于序列标注任务。它简化了 CRF 模型的实现和训练,提供了更高效的计算和更简便的接口。

具体来说,torchCRF 在以下方面发挥重要作用:

标签依赖建模:对于像命名实体识别(NER)这样的任务,标签之间并不是独立的。例如,标注“人名”标签(如 B-PER)后面可能会跟着另一个人名标签(如 I-PER),而且两个标签之间有依赖关系。CRF 就是为了捕捉这种依赖关系。

解码过程:在传统的分类模型中,预测每个标签是独立的,而在 CRF 中,我们不仅考虑当前标签,还考虑它与其他标签的关系。torchCRF 提供了高效的解码算法(如 维特比算法),用于推断给定输入序列最可能的标签序列。

训练和推理:使用 CRF 模型进行训练时,目标是最大化标签序列的条件概率。torchCRF 提供了 损失函数(如负对数似然损失)来训练 CRF 模型,并且通过 前向和后向算法 计算损失和梯度。

高效计算:torchCRF 基于 PyTorch,利用其 GPU 加速优势,使得 CRF 模型能够高效地处理大规模数据集。

- torchCRF 的核心功能

torchCRF 主要提供了以下核心功能:

前向传递(forward):计算每个标签的条件概率。

损失函数(forward_loss):计算条件随机场的负对数似然损失,适用于训练阶段。

解码(decode):使用 维特比解码算法(Viterbi algorithm)来推断最可能的标签序列。

序列标签预测:通过给定的输入序列和标签分数,预测整个标签序列。

- 如何使用 torchCRF

假设你已经有了一个基于 LSTM 或 BERT 等模型的编码器,输出的 每个 token 的标签分数,然后你可以使用 torchCRF 来对标签序列进行解码,捕捉标签之间的依赖关系。

示例代码: import torch from torchcrf import CRF

假设标签数量为 10,序列长度为 5

batch_size = 2 seq_len = 5 num_tags = 10

创建一个 CRF 实例,假设标签数为 num_tags

crf = CRF(num_tags, batch_first=True)

假设我们有一个输入 logits([batch_size, seq_len, num_tags])

logits = torch.randn(batch_size, seq_len, num_tags)

创建一个目标标签序列,维度为[batch_size, seq_len],这里的标签是整数

targets = torch.randint(0, num_tags, (batch_size, seq_len))

计算 CRF 的负对数似然损失

loss = crf(logits, targets) print("CRF Loss:", loss.item())

解码,得到最优的标签序列

best_paths = crf.decode(logits) print("Best paths:", best_paths)

- torchCRF 的应用场景

torchCRF 主要应用于需要进行 序列标注 或 标签依赖建模 的场景,常见的应用包括:

命名实体识别(NER):识别文本中的实体,如人名、地点名、公司名等。

词性标注(POS tagging):标注每个词的词性(名词、动词、形容词等)。

语音识别:将语音信号转化为文字,同时需要考虑发音与拼写的映射关系。

生物信息学中的序列标注任务:例如 DNA 或蛋白质序列的分析。

- 优点和局限性 优点:

考虑标签之间的依赖:torchCRF 能够捕捉标签之间的相互依赖性,这对于许多 NLP 任务(如 NER)至关重要。

高效推理:通过维特比算法等优化策略,torchCRF 提供了高效的解码过程。

易于集成:可以与现有的 PyTorch 模型(如 RNN, LSTM, Transformer)结合使用,用于处理更复杂的序列标注任务。

局限性:

训练复杂度较高:相较于其他模型,CRF 需要额外的计算和内存开销,尤其是在大规模数据集上训练时。

只能处理标签依赖关系:CRF 主要关注标签之间的依赖关系,对于输入特征之间的复杂关系建模较弱,可能不如 Transformer 模型那样具有全局的上下文建模能力。

- 总结

torchCRF 是一个用于 序列标注任务 中捕捉标签依赖关系的强大工具,特别适用于处理 命名实体识别、词性标注、语音识别 等任务。它通过条件随机场建模标签之间的依赖关系,提供了高效的训练和推理过程。如果你的任务涉及标签之间的相互依赖,torchCRF 将非常适合你。

集成情感分析与 NER 模型

情感分析通常分为以下几类:

情感极性:如 积极、消极 或 中立。 情感强度:如 强烈、中等 或 轻微。 情感方向:例如,用户可能对某些特征(如价格、面积、位置等)表示 喜欢 或 不喜欢。

- 结合 NER 与情感分析:对用户输入进行 NER,识别出价格、面积、地点等实体;然后根据情感分析结果调整这些实体的过滤条件。

- 情感优先级:在用户的输入中,情感因素可以作为 权重 来影响房源的排序。例如,如果用户对某一地点有强烈的消极情感,可以将该地点的房源从结果中排除。

import spacy

from transformers import pipeline

# 加载spaCy的NER模型

nlp = spacy.load("zh_core_web_sm")

# 使用 Hugging Face 的情感分析模型

sentiment_analyzer = pipeline("sentiment-analysis")

# 情感分析和NER结合

def analyze_user_input(text):

# NER分析

doc = nlp(text)

entities = [(ent.text, ent.label_) for ent in doc.ents]

# 情感分析

sentiment_result = sentiment_analyzer(text)

sentiment_label = sentiment_result[0]['label']

sentiment_score = sentiment_result[0]['score']

return entities, sentiment_label, sentiment_score

# 示例输入

text = "我在浦东新区花木路附近租房,预算八千左右,面积40平方米左右"

# 分析输入

entities, sentiment_label, sentiment_score = analyze_user_input(text)

print(f"NER 结果: {entities}")

print(f"情感分析标签: {sentiment_label}, 情感得分: {sentiment_score}")

基于多模态信息的推荐

考虑将房源的 文本描述、图片、位置 等多模态信息结合起来进行推荐。这种方法通过 融合不同类型的数据 来生成推荐,从而能更全面地满足用户需求。

具体实现:

文本分析:通过 NLP 技术提取房源的关键特点(如位置、价格、设施等)。

图像分析:通过计算机视觉模型分析房源图片中的特点(如房间布局、装修风格等)。

位置分析:结合位置数据(如距离地铁站、周围商圈)为用户推荐合适的房源。

综合多模态数据后,通过推荐算法生成个性化推荐。

优点:

更全面地理解用户需求,综合考虑多种因素来推荐房源。

能处理更多类型的用户输入,适合对房源多维度评估的场景。

局限:

需要多模态数据的支持,并且处理和训练这些数据较为复杂。

计算资源消耗较大,尤其是在处理图像和多模态融合时。

LLaMA Factory 核心定位

LLaMA Factory是开源大模型微调 / 训练 / 部署全流程工具包,主打低代码 / 零代码、多模型兼容、PEFT 高效微调,覆盖 SFT/RM/PPO/DPO 等,适配 LLaMA、Qwen、ChatGLM、Mistral 等 100 + 主流模型,支持 LoRA/QLoRA/DoRA 等 PEFT 与量化,WebUI+CLI 双入口,显存占用低(4bit QLoRA 可在消费级 GPU 运行),适合快速定制 LLM 用于下游任务

尽可能多的列举编程思想及对应的适用场景, 比如创建型思想中的单例模式,确保一个类仅有一个实例,并提供全局访问点,应用场景: 全局配置管理,日志工具类,连接池

编程思想的核心价值是解耦、复用、扩展、可维护,选择时需遵循:

- 简单场景优先基础思想(如面向过程、单一职责),避免过度设计;

- 复杂场景优先成熟模式(如工厂、观察者、微服务),提升扩展性;

- 架构级场景优先分层、DDD、微服务等,保障系统整体稳定性;

- 始终以“业务需求”为核心,匹配思想的适用场景,而非为了用模式而用模式。

一、创建型思想(聚焦对象创建,解耦创建逻辑与使用逻辑)

| 编程思想/模式 | 核心定义 | 适用场景 | 优势/解决的问题 |

|---|---|---|---|

| 单例模式 | 确保一个类仅有一个实例,并提供全局访问点 | 1. 全局配置管理(如数据库配置、系统参数) 2. 日志工具类 3. 连接池(数据库/Redis) 4. 缓存管理器 |

避免重复创建实例导致资源浪费,保证全局状态一致性;防止多实例冲突(如连接池重复初始化) |

| 工厂模式(简单/工厂方法/抽象工厂) | 简单工厂:一个工厂类创建不同类型对象; 工厂方法:子类决定创建哪种对象; 抽象工厂:创建一系列相关对象 |

1. 简单工厂:对象创建逻辑简单(如根据类型创建不同形状:圆形/方形) 2. 工厂方法:产品种类扩展频繁(如不同数据库驱动:MySQL/Oracle) 3. 抽象工厂:需要创建成套产品(如 UI 组件库:Windows 风格/移动端风格) |

解耦对象创建与使用,降低修改成本;符合“开闭原则”,新增产品无需修改原有创建逻辑 |

| 建造者模式 | 将复杂对象的构建与表示分离,分步构建对象 | 1. 复杂对象创建(如订单对象:包含商品、地址、支付方式等多属性) 2. 生成器(如 SQL 构建器、JSON 构建器) 3. 配置对象(如分布式系统的节点配置) |

避免“参数爆炸”(构造函数参数过多);控制对象构建流程,保证对象完整性 |

| 原型模式 | 通过复制已有实例(原型)创建新对象,而非重新实例化 | 1. 对象创建成本高(如大对象、IO 密集型对象) 2. 需要批量创建相似对象(如游戏角色克隆) 3. 动态生成对象(如根据模板生成报表) |

提升创建效率,避免重复初始化;支持动态克隆,灵活扩展 |

| 懒加载(延迟初始化) | 延迟对象创建/资源加载,直到首次使用时才执行 | 1. 大资源加载(如图片、视频、大文件) 2. 低优先级服务初始化(如后台统计服务) 3. 高内存占用对象(如大数据缓存) |

减少启动时间,降低内存占用;避免无用对象占用资源 |

二、结构型思想(聚焦对象/模块的组合,优化结构灵活性)

| 编程思想/模式 | 核心定义 | 适用场景 | 优势/解决的问题 |

|---|---|---|---|

| 适配器模式 | 将一个类的接口转换成客户端期望的另一个接口,兼容不兼容的接口 | 1. 第三方库适配(如不同支付 SDK:支付宝/微信支付统一接口) 2. 旧系统升级兼容(如老接口适配新业务逻辑) 3. 跨平台适配(如不同操作系统的文件操作) |

无需修改原有代码即可复用现有类;降低系统耦合,提升兼容性 |

| 装饰器模式 | 动态给对象添加额外职责,不改变原有结构 | 1. 功能扩展(如日志装饰器、权限装饰器、缓存装饰器) 2. 多层功能叠加(如请求处理:校验 → 日志 → 限流) 3. 可选功能配置(如电商订单:优惠券 → 满减 → 积分) |

比继承更灵活,可动态增删功能;符合“开闭原则”,扩展不修改原有代码 |

| 代理模式(静态/动态) | 为对象提供代理类,控制对原对象的访问(如权限、延迟、日志) | 1. 远程代理(RPC 调用、分布式服务) 2. 保护代理(权限控制:如管理员/普通用户访问资源) 3. 虚拟代理(图片懒加载、大文件加载) 4. 日志/监控代理 |

解耦访问逻辑与业务逻辑;增强对象控制能力,无需修改原对象 |

| 组合模式 | 将对象组合成树形结构,统一处理单个对象和组合对象 | 1. 目录文件系统(文件/文件夹统一操作) 2. 组织机构树(部门/员工统一管理) 3. UI 组件树(按钮/容器统一渲染) 4. 权限树(菜单/按钮统一校验) |

简化树形结构操作,客户端无需区分单个/组合对象;易于扩展新节点类型 |

| 桥接模式 | 将抽象与实现分离,使二者可独立变化(解耦维度) | 1. 跨平台功能(如“形状+颜色”:圆形/方形 与 红色/蓝色独立扩展) 2. 多维度扩展(如“支付方式+支付渠道”:微信/支付宝 与 扫码/刷卡) 3. 驱动程序(如“设备+协议”:打印机/扫描仪 与 TCP/UDP) |

避免多维度扩展导致的类爆炸;抽象和实现可独立升级,降低耦合 |

| 享元模式 | 复用细粒度对象,减少内存占用(池化思想) | 1. 池化场景(线程池、连接池、对象池) 2. 大量相似对象(如游戏中的粒子、字符缓存池) 3. 高频创建对象(如电商订单的状态对象、日志级别对象) |

降低内存消耗,提升创建效率;控制实例数量,避免频繁 GC |

| 外观模式 | 为复杂子系统提供统一入口,简化客户端调用 | 1. 复杂系统封装(如电商下单:整合库存、支付、物流、通知子系统) 2. 第三方 API 封装(如整合多个 SDK 为统一接口) 3. 微服务网关(封装多个微服务调用) |

降低客户端与子系统的耦合;简化调用逻辑,减少客户端代码复杂度 |

三、行为型思想(聚焦对象间的交互,优化通信与职责分配)

| 编程思想/模式 | 核心定义 | 适用场景 | 优势/解决的问题 |

|---|---|---|---|

| 观察者模式(发布-订阅) | 定义一对多依赖,当一个对象状态变化时,所有依赖者自动收到通知 | 1. 事件驱动系统(如前端 DOM 事件、后端消息通知) 2. 消息队列(如 Kafka/RabbitMQ 的发布订阅) 3. 状态监控(如系统监控、数据变更通知) 4. 业务通知(如订单状态变更 → 通知用户/库存/物流) |

解耦发布者与订阅者;支持广播通知,易于扩展订阅者 |

| 策略模式 | 定义一系列算法,封装成独立策略类,可动态切换 | 1. 算法切换(如排序算法:冒泡/快排/归并、支付算法:微信/支付宝/银联) 2. 业务规则(如优惠券计算:满减/折扣/立减) 3. 校验规则(如表单校验:手机号/邮箱/身份证) |

避免大量 if-else 分支;算法可独立扩展,符合“开闭原则” |

| 模板方法模式 | 定义算法骨架,将可变步骤延迟到子类实现 | 1. 固定流程+可变步骤(如流程引擎:审批流程、测试流程) 2. 框架设计(如 Spring 的 JdbcTemplate、MyBatis 的 BaseMapper) 3. 业务流程(如订单处理:创建 → 校验 → 支付 → 发货,其中校验/支付可变) |

复用固定逻辑,简化子类代码;控制算法流程,保证核心逻辑一致性 |

| 迭代器模式 | 提供统一方式遍历集合,隐藏集合内部结构 | 1. 自定义集合遍历(如链表、树、哈希表的统一遍历) 2. 多集合统一处理(如同时遍历 List、Set、Map) 3. 分页遍历(如数据库分页、大数据集合分片遍历) |

解耦遍历逻辑与集合结构;客户端无需关注集合类型,统一遍历方式 |

| 责任链模式 | 将请求沿处理链传递,直到有处理者处理该请求 | 1. 请求过滤/处理(如 HTTP 拦截器、日志过滤器) 2. 审批流程(如请假审批:组长 → 部门经理 → 总监) 3. 异常处理(如多层异常捕获) 4. 权限校验(如接口权限:登录 → 角色 → 数据权限) |

解耦请求发送者与处理者;可动态调整处理链,灵活扩展 |

| 命令模式 | 将请求封装成命令对象,解耦请求发起与执行 | 1. 操作记录/撤销(如编辑器的撤销/重做、订单的取消/恢复) 2. 异步任务(如任务队列、定时任务) 3. 远程调用(如 RPC 命令、接口调用封装) 4. 批量操作(如批量删除、批量更新) |

支持撤销/重做、日志记录;解耦调用者与执行者,易于扩展新命令 |

| 状态模式 | 将对象状态封装成独立类,状态变化时切换状态类 | 1. 状态驱动业务(如订单状态:待支付 → 已支付 → 待发货 → 已发货 → 完成) 2. 有限状态机(如游戏角色状态:待机 → 移动 → 攻击 → 死亡) 3. 设备状态(如电梯:停止 → 运行 → 开门 → 关门) |

避免大量状态判断的 if-else;状态可独立扩展,符合“开闭原则” |

| 备忘录模式 | 保存对象状态,以便后续恢复(快照思想) | 1. 撤销/恢复(如编辑器、配置修改回滚) 2. 快照备份(如数据库快照、系统配置快照) 3. 事务回滚(如数据库事务、分布式事务) |

不破坏对象封装性的前提下保存状态;支持多版本恢复,提升系统容错性 |

| 中介者模式 | 用中介者对象封装多个对象间的交互,减少对象间直接耦合 | 1. 多组件交互(如 UI 组件:按钮、输入框、弹窗通过中介者通信) 2. 分布式系统(如微服务注册中心、消息中间件) 3. 游戏场景(如游戏管理器:玩家、怪物、道具通过管理器交互) |

减少对象间直接依赖,降低耦合;集中管理交互逻辑,易于维护和扩展 |

| 访问者模式 | 定义新操作而不修改被操作对象,将操作与数据结构分离 | 1. 数据结构稳定但操作多变(如 AST 语法树遍历、XML/JSON 解析) 2. 多维度数据处理(如报表生成:同一数据集生成不同报表) 3. 复杂对象遍历(如对象树的多规则校验) |

新增操作无需修改原有数据结构;集中管理相关操作,提升代码复用性 |

| 解释器模式 | 定义语言文法,构建解释器解释语言中的表达式 | 1. 自定义规则引擎(如风控规则、优惠券规则) 2. 表达式解析(如数学表达式、SQL 解析、正则表达式) 3. 领域特定语言(DSL)(如配置文件解析、脚本解释器) |

灵活扩展文法规则;可直接解析自定义表达式,适配业务规则动态调整 |

四、通用编程思想(跨场景的核心思想)

| 编程思想 | 核心定义 | 适用场景 | 优势/解决的问题 |

|---|---|---|---|

| 面向对象(OOP) | 以对象为核心,封装、继承、多态 | 绝大多数业务系统(如电商、金融、ERP) 复杂系统设计(如框架、中间件) 需要复用/扩展的场景 |

代码复用性高,易于维护;封装性好,降低耦合;多态提升灵活性 |

| 面向过程(POP) | 以流程/函数为核心,按步骤实现功能 | 简单工具类(如脚本、小工具) 高性能场景(如嵌入式、底层算法) 一次性任务(如数据清洗脚本) |

执行效率高,逻辑直观;代码量少,开发速度快 |

| 函数式编程(FP) | 强调纯函数、不可变数据、函数作为一等公民 | 数据处理(如大数据分析、流处理) 并发编程(如多线程无状态操作) 响应式编程(如 RxJava、React) |

减少副作用,线程安全;代码简洁,易于测试;支持函数组合和惰性求值 |

| 面向切面(AOP) | 提取横切逻辑(日志、权限、事务),动态织入业务逻辑 | 通用功能复用(如日志、监控、异常处理) 事务管理(如 Spring 事务) 权限控制(如接口拦截、数据权限) |

解耦横切逻辑与业务逻辑;统一管理通用功能,避免代码冗余 |

| 面向接口编程 | 依赖接口而非具体实现,定义契约 | 模块化开发(如微服务、插件化系统) 框架设计(如 Spring、MyBatis) 第三方依赖适配 |

降低耦合,提升扩展性;便于测试(Mock 接口);符合“依赖倒置原则” |

| 模块化/组件化 | 将系统拆分为独立模块/组件,高内聚低耦合 | 大型系统(如电商平台、中台系统) 跨团队协作(如前端组件库、后端微服务) 可复用组件开发 |

便于分工协作,降低维护成本;支持独立部署/升级,提升系统稳定性 |

| 微内核思想 | 核心功能极简,扩展功能通过插件实现 | 框架/中间件(如 Spring Boot、浏览器内核) 可定制系统(如 ERP、CRM) 低代码平台 |

核心稳定,扩展灵活;按需加载插件,降低资源占用 |

| 分层思想 | 按职责拆分系统为多层(如表现层、业务层、数据层) | 企业级应用(如 MVC、三层架构) 微服务(如 API 层、服务层、数据层) 分布式系统 |

职责清晰,便于维护;每层可独立扩展,降低修改风险 |

| 开闭原则 | 对扩展开放,对修改关闭 | 所有需要长期维护、频繁扩展的系统(如电商、金融、框架) | 减少修改原有代码带来的风险;提升系统扩展性,符合可持续迭代 |

| 迪米特法则(最少知道) | 一个对象应尽可能少地知道其他对象,降低耦合 | 大型分布式系统、微服务、组件化开发 | 减少对象间依赖,提升代码可维护性;降低系统复杂度,便于测试 |

| 单一职责 | 一个类/方法只负责一个职责 | 所有业务模块、工具类、接口设计 | 代码可读性高,易于维护;降低修改风险,一个职责变化不影响其他职责 |

| 依赖倒置 | 高层模块依赖抽象,底层模块实现抽象 | 框架设计、模块化开发、插件化系统 | 降低高层与底层的耦合;提升系统扩展性,底层实现可灵活替换 |

| 里氏替换 | 子类可替换父类而不改变程序正确性 | 继承体系设计、多态场景 | 保证继承体系的正确性;提升代码复用性,子类可扩展但不破坏父类逻辑 |

| 开闭原则 | 对扩展开放,对修改关闭 | 频繁迭代的业务系统、框架开发 | 减少修改原有代码的风险,扩展新功能无需改动老代码 |

五、架构级思想(宏观系统设计)

| 编程思想/架构模式 | 核心定义 | 适用场景 | 优势/解决的问题 |

|---|---|---|---|

| 微服务架构 | 将单体系统拆分为独立部署的小型服务,服务间通过网络通信 | 大型复杂系统(如电商、金融、互联网平台) 高可用/高扩展需求的系统 跨团队协作的系统 |

服务独立部署/升级,提升可用性;按需扩展,资源利用率高;技术栈灵活 |

| 分布式思想 | 将任务分散到多个节点执行,协同完成目标 | 大数据处理(如 Hadoop、Spark) 高并发系统(如秒杀、直播) 高可用系统(如异地多活) |

提升处理能力和并发量;降低单点故障风险,提升系统容错性 |

| 事件驱动 | 基于事件发布-订阅,异步响应事件触发的业务 | 高并发异步系统(如电商下单、支付回调) 解耦的微服务架构 实时数据处理(如监控、风控) |

解耦服务间依赖,提升系统弹性;支持异步处理,提升并发能力 |

| 领域驱动设计(DDD) | 以业务领域为核心,将业务模型映射为代码模型 | 复杂业务系统(如金融、电商、ERP) 业务与技术融合的场景 大型团队协作的系统 |

对齐业务与技术,降低沟通成本;领域模型可复用,提升系统可维护性 |

| 管道-过滤器 | 将处理流程拆分为管道(数据传输)和过滤器(数据处理),串联执行 | 数据处理流程(如 ETL、日志处理) 请求处理链(如 HTTP 请求过滤) 批量任务处理 |

流程可灵活组合,易于扩展;过滤器可复用,降低代码冗余 |

| 分层架构 | 按职责将系统分为表现层、业务层、数据层等,层间单向依赖 | 绝大多数业务系统(如 MVC、三层架构) 企业级应用、中台系统 |

职责清晰,便于维护;层间解耦,可独立升级 |

| 六边形架构(端口-适配器) | 核心业务逻辑与外部依赖解耦,通过适配器接入外部系统 | 高内聚低耦合的业务系统 需要适配多外部系统的场景 易测试的系统 |

核心业务逻辑不依赖外部;易于替换外部依赖,提升系统灵活性 |

使用 Transformer 训练数据的过程中经常会遇到哪些哪些方面的问题?然后对应解决方案是什么?

在基于 Transformer 训练数据的过程中,会面临数据层面、训练效率、模型性能、硬件适配四大类核心问题,以下是针对性问题及解决方案,结合房源短文本场景优化:

一、 数据层面问题

问题1:数据质量差(噪声多、格式混乱)

- 具体表现:房源信息存在字段缺失(如经纬度为空)、重复数据(同一房源多条记录)、文本歧义(如“朝南”表述为“南向”“南朝向”)

- 解决方案:

- 清洗:用 Python 脚本去重、补全缺失字段,统一文本表述(如将“南向”“南朝向”归一为“朝南”)

- 过滤:剔除无效数据(如经纬度不在合理范围的记录)

- 标准化:将房源信息按固定模板格式化(

{name}_{location}_{lng}_{lat}_{direction})

问题2:数据量不足(仅90+条房源数据,易过拟合)

- 具体表现:模型在训练集上表现好,在新房源数据上检索/生成效果差

- 解决方案:

- 数据增强:对短文本做同义替换(如“一室一厅”→“1室1厅”)、字段重组(保持核心信息不变,调整语序)

- 迁移学习:先用通用房产领域数据集预训练嵌入模型,再用自有90+条数据微调

- 引入伪标签:借助轻量 LLM 对相似房源生成标注,扩充训练样本

问题3:数据分布不均(如某区域房源占比过高)

- 具体表现:模型对占比高的区域房源检索精准,对小众区域识别差

- 解决方案:

- 分层采样:按房源区域、朝向等维度分层划分训练/验证集,保证各维度样本占比均衡

- 加权训练:对小众类别样本设置更高的损失权重,提升模型对其关注度

二、 训练效率问题

问题1:显存不足(Transformer 多头注意力机制显存消耗大)

- 具体表现:训练时出现

CUDA out of memory错误,尤其微调 8B 级模型时 - 解决方案:

- 量化训练:启用 4bit/8bit 量化(如使用 bitsandbytes 库),降低参数精度

- 梯度累积:增大

gradient_accumulation_steps,等效提升 batch size 同时降低显存占用 - 模型裁剪:针对房源短文本场景,裁剪 Transformer 冗余的注意力头和网络层

- 具体表现:训练时出现

问题2:训练速度慢(小批量+单卡训练周期长)

- 具体表现:单卡训练一轮耗时过久,迭代效率低

- 解决方案:

- 混合精度训练:开启 FP16/BF16 精度,减少计算量同时保证精度

- 分布式训练:用 torchrun 启动多卡训练,分摊计算压力

- 优化数据加载:使用

Dataset类+多进程加载(num_workers>0),减少数据读取阻塞

三、 模型性能问题

问题1:过拟合(训练集 loss 持续下降,验证集 loss 上升)

- 具体表现:模型死记硬背训练集房源信息,对新数据泛化能力弱

- 解决方案:

- 正则化:加入权重衰减(

weight_decay=1e-4)、Dropout(注意力层 dropout=0.1) - 早停策略:监控验证集指标(如检索召回率),指标不再提升时停止训练

- 降低模型复杂度:选用轻量 Transformer 变体(如 DistilBERT),减少参数数量

- 正则化:加入权重衰减(

问题2:注意力机制失效(关键信息捕捉不到)

- 具体表现:模型无法聚焦房源核心字段(如经纬度、朝向),检索时匹配错误

- 解决方案:

- 注意力掩码:针对结构化房源文本,设置掩码强制模型关注关键字段(如经纬度位置)

- 对比学习:构建正负样本对(如同一小区不同朝向为负样本),提升模型区分能力

- 领域适配:在 Transformer 嵌入层后添加房源领域适配层,强化关键词表征

问题3:推理延迟高(实时性差,不适合租房APP)

- 具体表现:模型检索/生成响应时间长,影响用户体验

- 解决方案:

- 模型量化:推理时启用 INT8 量化,降低计算延迟

- 向量索引优化:使用 FAISS 暴力检索(数据量仅90+条),替代复杂索引算法

- 剪枝:移除模型中贡献度低的神经元和注意力头,精简模型结构

四、 硬件适配问题

- 问题1:硬件资源受限(无高端 GPU,仅能本地单卡训练)

- 具体表现:无法加载大模型,训练时频繁显存溢出

- 解决方案:

- 选用轻量模型:优先使用 all-MiniLM-L6-v2、DistilBERT 等小参数量模型

- 梯度检查点:开启

gradient_checkpointing,以牺牲少量计算速度换取显存节省 - CPU 训练备选:若无 GPU,使用 Hugging Face

transformers库的 CPU 优化模式,适合小数据量训练

AI 提问

核心思路是从基础算法能力、机器学习实战、租房场景落地和工程与协作素养四个维度设计问题,全面考察候选人。

一、基础算法与数据结构(考察基本功) 这部分是筛选的基础,确保候选人有扎实的算法功底,能应对复杂问题的拆解。 请解释一下哈希表的原理,以及在处理租房数据(如用户 ID 映射房源)时,如何解决哈希冲突? 给定一个房源列表,每个房源包含 “面积”“价格”“距离地铁口距离” 三个字段,请设计一个算法,找出 “面积 ≥60㎡” 且 “价格 ≤5000 元” 的房源中,“距离地铁口最近” 的 Top10,说明时间复杂度。 红黑树和平衡二叉树有什么区别?在租房应用的 “房源价格排序” 功能中,为什么更推荐用红黑树而非平衡二叉树? 二、机器学习与推荐系统(考察核心业务能力) 租房应用的核心算法场景是推荐,这部分直接决定候选人能否落地核心功能。 租房推荐和电商商品推荐的核心差异是什么?在设计推荐模型时,你会优先考虑哪些租房特有的特征(如通勤时间、租期、户型适配度)? 假设用户刚注册时没有任何行为数据,如何设计 “冷启动” 推荐策略,让新用户快速看到合适的房源? 常用的推荐算法(协同过滤、逻辑回归、深度学习模型)各有什么优缺点?如果租房应用的用户量突增 10 倍,你会选择哪种模型,为什么? 如何评估推荐系统的效果?除了 “点击率”“转化率”,还能引入哪些租房场景特有的指标(如 “房源收藏率”“咨询率”“看房邀约率”)? 三、租房场景专项问题(考察业务理解与问题解决) 这部分能筛选出 “懂算法更懂业务” 的候选人,避免算法与实际场景脱节。 如何设计算法,识别租房数据中的 “虚假房源”?请列举 3 个以上虚假房源的特征(如图片重复、价格远低于同区域均价、描述与图片不符),并说明对应的检测逻辑。 很多用户会在租房时输入模糊需求(如 “靠近 XX 公司”“周边有幼儿园”),如何将这种自然语言需求转化为可计算的筛选条件(如经纬度范围、周边配套标签)? 租房价格受季节(毕业季涨价)、政策(学区变动)、供需关系影响很大,如何设计时序模型,预测未来 3 个月某小区的租金走势?需要用到哪些数据? 当用户同时筛选 “低价格”“近地铁”“大户型” 三个互相矛盾的需求时(如预算 3000 元想租地铁口 100㎡ 房源),算法该如何处理?是返回折中结果,还是引导用户调整需求? 四、工程能力与协作(考察落地与团队适配) 算法最终要落地成产品,这部分考察候选人的工程思维和团队协作能力。 如果你训练的推荐模型在离线测试中效果很好,但上线后用户点击率反而下降,可能的原因有哪些?如何排查和解决? 租房应用的房源数据实时更新(如房源被租、价格变动),如何设计数据 pipeline,确保算法模型能实时获取最新数据,且不影响线上服务性能? 当产品经理提出 “要让推荐结果里多出现新上线的房源”,但这可能会降低短期点击率时,你会如何与产品经理沟通,平衡 “用户体验” 和 “业务目标(新房源曝光)”? 你会用哪些工具或框架来部署算法模型(如 TensorFlow Serving、PyTorch Serve)?在部署时,如何保证模型的响应时间控制在 100ms 以内(满足租房应用的实时推荐需求)?

以下是针对 AI 智能租房应用算法工程师岗位的结构化面试评分表,结合前文四大考察维度,明确每个问题的核心考察点、评分标准及加分/扣分点,方便量化评估候选人能力(满分 100 分,60 分合格,80 分以上为优秀)。

Page Source